聊起 AI,画面都充斥着机械语言:精密高级的芯片,光怪陆离的智能产业……你眼中的 AI 有什么样的能力?能给传统行业带来哪些变革与发展?基于此,腾讯云开发者社区联手知乎科技,从知乎AI 与传统行业相关话题中精选内容落地社区专题「 AI 与传统行业的融合 」。

本文为“AI 将如何影交通”的精华内容分享。

红绿灯调配是一个技术活,传统方法主要由手工制作的规则操作,根据道路和车流来预先设定时间。交叉学科的好处就显现出来了:看看CS业界有啥新东西,拿来主义,修改输入和网络结构,bling! 新文章出来咯。强化学习搞红绿灯配时十几年前就有人干过,这不最近深度学习深入人心火的不行,强化学习的policy网络直接上深度网络呗,反正有显卡有内存。根据鄙人的见识,交叉学科对比CS前沿会有3年左右的代差。深度强化学习和交通流控制是个好伙伴,因为要根据试试车流量,在很多路口协调控制,手动模型恐怕在人为设计的时候没法满足协同,动态调整的要求。

用强化学习解决交通灯控制问题通常表现出比手动交通灯模型有更好的性能。有的方法使用每个车辆的位置,等待车辆的数量来作为observation。然而,这种算法要巨大的存储空间,在过去并不流行。最近研究提出的深度 Q-learning方法,使用连续状态表示,特征提取采用手动模型(队列长度,平均延迟)或者图像特征。感觉图像更符合seq2seq的精神,因为使用的是路口照片喂进网络进行学习。

本文来自KDD2018 IntelliLight: A Reinforcement Learning Approach for Intelligent Traffic Light Control | Request PDF

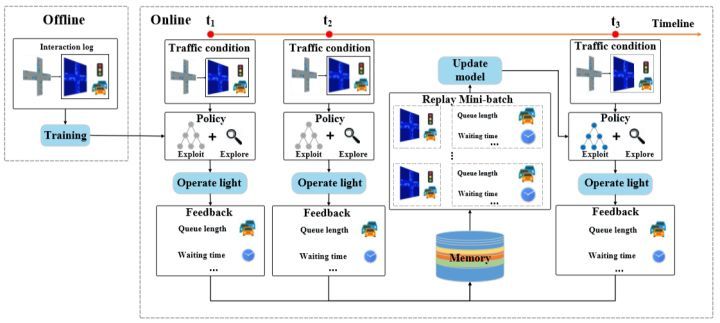

运行机制:offline是预先设定固定的红绿灯相位采集数据,online就是agent开始介入进行学习,并把一定时间序列的state,agent,reward存入数据库。

State: 就是路口的情况,包括等待车辆数,车辆距离路口距离,路口抽象车辆图片等等。

Action:就是红灯变绿灯,绿灯变红灯(不考虑黄灯)

Reward:奖励是由以下几个因素影响的

(1)等灯车队长度

(2)延误,就是当前车道的平均车速和限速之间的关系

(3)等待时间(小于0.1km/h就算静止)

(4)红绿灯变换次数

(5)顺利通过交叉路口的车辆数

(6)所有车辆通过路口的总时间

这些参数的权重预先设定,agent的任务就是在畅销时间内使得reward最大

上图就是网络结构,图像特征是从交通状况的观察中提取出来的:队列长度L,等待时间W,红绿灯阶段P,总车辆数量V,相连接集成成输入。当阶段P = 0时,左翼分支将被激活,而当相位P = 1时,右边将会激活分支。有一点想不通,喂入网络的那张蓝色图片是那种简化后的车辆位置抽象图,没有局部细节值得卷积,所以我疑惑这个CNN用在这里是何原理?已经给一作发了邮件,得到回付是:The image is used to capture some features that we didn’t notice, like the relative position of vehicles, etc. And the experiments shows that these features is helpful. 这里再次保留意见。

另外作者还使用了一个技巧memory palace,就是把不同情况分类后放入memory中,这样就能消除不平衡的情况,如下图所示

这是作者在复杂路况下进行的测试(SUMO仿真软件),上面三个都是其他方法,下面的是纯粹版,纯粹版加memory palace,纯粹版加memory palace加左右分支激活

个人思考:

这些reward参数的权重预先设定,不如用全连接去学

CNN 做提取 需要对车型敏感,所以简化图可能并不是最优的输入。

转载来源:李同学

链接:https://zhuanlan.zhihu.com/p/44959243

来源:知乎 著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。